摘要:新版《义务教育信息科技课程标准》将计算思维作为全学段培养目标,其有效测评是检验培养效果和监测学生相关能力发展的关键。计算思维不仅涉及从计算机科学视角解决编程相关问题的能力,还涉及从普适化视角解决日常学习与生活问题的能力。基于计算概念、计算实践、计算观念三维框架构建的计算思维综合测评方案,通过整合上述两种视角,能够全面反映学生计算思维发展水平。运用该方案对S市4~6年级小学生计算思维水平进行测评后发现:其测评工具信效度良好,可用于综合评价小学生的计算思维发展;小学生计算思维水平整体表现中等,在计算概念的分支结构、简单函数方面以及计算观念的“分解”维度上仍有待提升;小学生计算思维水平在性别和年级上存在显著差异,男生在计算概念、计算实践以及计算观念的部分维度上显著优于女生。未来,应当注重从多角度综合评价小学生的计算思维水平,通过情境问题解决促进小学生计算思维培育,并针对不同性别学生采取差异化计算思维培养策略。

关键词:计算思维测评;三维框架;计算概念;计算实践;计算观念

随着计算机科学特别是人工智能技术的飞速发展,人们的生产生活方式正经历着前所未有的变化,这对未来人才所应具备的适应信息时代的素养提出了新要求。计算思维(Computational Thinking)作为信息时代的一种基本素养,其培养受到全球范围内的广泛关注,并逐渐从高等教育延伸到K-12教育领域,呈现出愈加“低龄化”的趋势(周佳伟等,2018)。美国、英国、澳大利亚等国均发布了促进K-12阶段学生计算思维发展的相关政策文件(孙丹等,2019),我国也在《义务教育信息科技课程标准(2022年版)》(以下简称《信息科技新课标》)和《普通高中信息技术课程标准》中将计算思维作为学科核心素养之一(中华人民共和国教育部,2020;2022),并在义务教育各学段明确了对应的课程目标(中华人民共和国教育部,2022)。基础教育阶段(尤其是小学阶段)学生正处于行为、习惯形成的关键时期,必须格外重视其计算思维的培养(范文翔等,2018),而科学有效的计算思维测评则是检验培养效果和监测学生相关能力发展的关键。然而,现有的计算思维测评工具多聚焦于学习者的主观自我评价或编程能力测试,缺少对其计算思维发展的全方位测量(惠恭健等,2020)。因此,有学者指出应考虑计算思维与计算机科学、认知心理学等领域的复杂关联,从“普适化”和“计算机科学”相结合的视角对学习者的计算思维水平进行综合测评(Polat et al.,2021)。基于此,本研究以融合计算概念、计算实践和计算观念的计算思维三维框架为基础,整合计算思维的“普适化”和“计算机科学”视角,构建面向小学生的计算思维综合测评方案,并实证分析该方案的有效性,旨在为我国小学生计算思维培养和测评提供借鉴和启示。

一、文献综述

1.计算思维的内涵

计算思维概念自提出以来便引发研究者的广泛关注,并形成了一系列经典定义。2006年,周以真(Jeannette M. Wing)对西蒙·派珀特(Seymour Papert)于1980年首次提出的“计算思维”进行了界定,指出“计算思维就是利用计算机科学的基本理念来进行问题求解、系统设计和理解人类行为等涵盖计算机科学之广度的一系列思维活动”(Wing,2006)。2008年,周以真再次对该定义进行了修正,认为“计算思维是与形式化问题及其解决方案相关的思维过程,其解决问题的表示形式应该能有效地被信息处理代理执行”(Wing,2008)。2011年,美国计算机科学教师协会(CSTA)和国际教育技术协会(ISTE)发布了《K-12教育计算思维的操作性定义》(Operational Definition of Computational Thinking for K-12 Education),其中阐释了解决计算问题时运用计算思维而表现出的能力,包括但不限于:对问题的理解、阐述与抽象;算法设计;收集、分析与组织数据;归纳并泛化成可以解决其他问题的方法(ISTE & CSTA,2011)。Denning(2017)指出,计算思维是学生在解决计算机科学或编程相关问题时所需的特定知识或技能。也有研究者指出,计算思维应该被视为一种思维过程(Guzdial,2008),它是学生在学习过程中必须具备的基本素养和能力(Duncan et al.,2015),并且能被嵌入不同的学科领域(Denning,2007),具有广泛的适用性和“人人受益”的价值。在我国学者关于计算思维内涵的阐释中,朱亚宗(2009)认为其是人类三大科学思维方式(包括理论思维、实验思维、计算思维)之一。蒋宗礼(2013)认为,计算思维是一种与计算机及其特有的问题求解方式紧密相关的思维形式,即有意识地使用计算机科学家们所采用的思想、方法、技术和工具。任友群等(2016)也指出,计算思维能够为分析和解决工作、学习和生活中的各种问题提供新的视角,是支持个体终身发展的重要素养。通过梳理计算思维的内涵不难发现,学界主要基于两种视角来界定计算思维:一种是从计算机科学视角出发,强调计算思维与解决计算机科学和编程相关问题的联系;另一种则从普适化视角出发,将计算思维泛化,并将其与日常生活和学习中解决问题所需的能力相关联。因此,面向计算思维的测评也可以通过整合这两种视角来展开,从而更全面地了解学习者的计算思维发展。

2. K-12 阶段计算思维测评工具

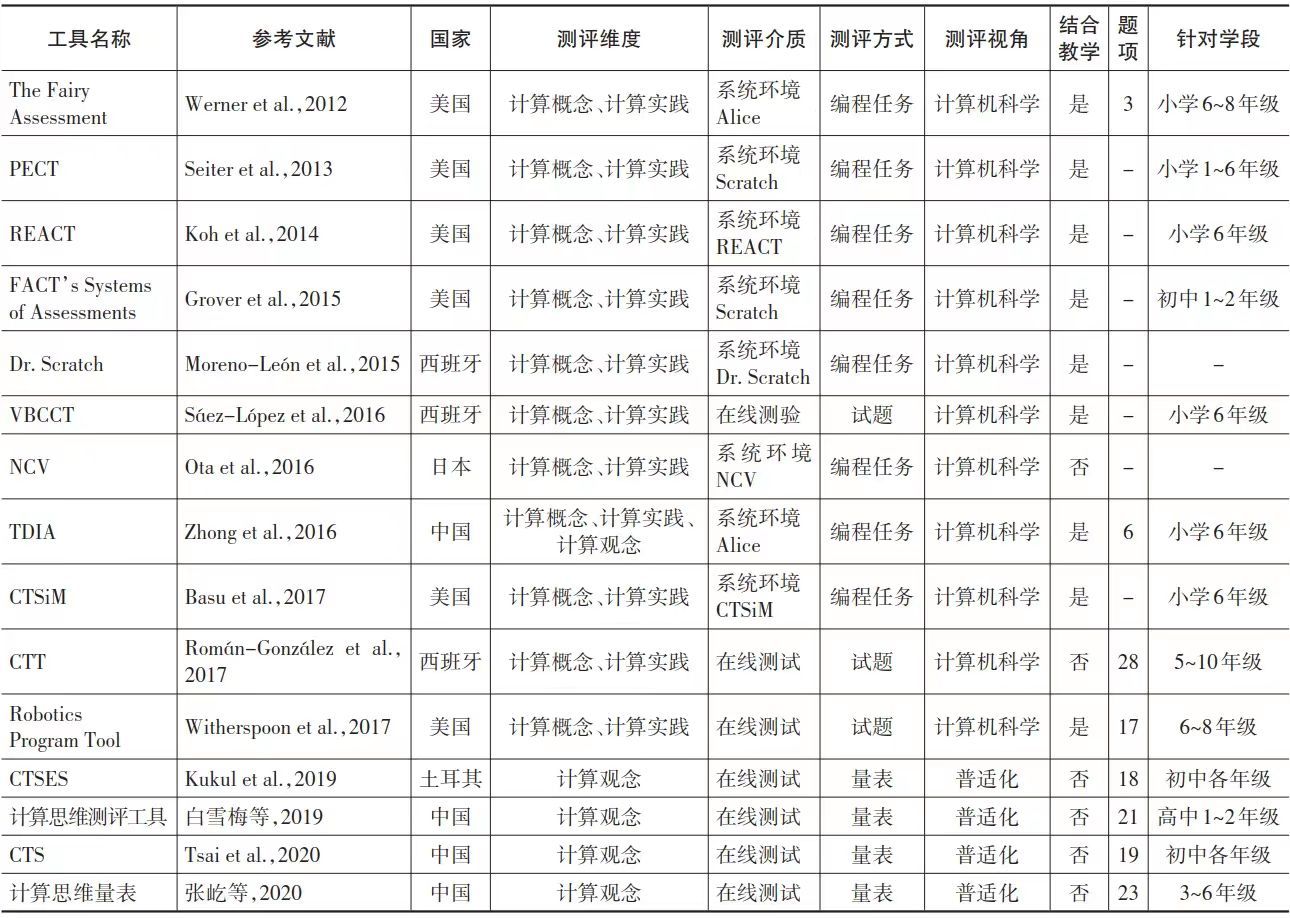

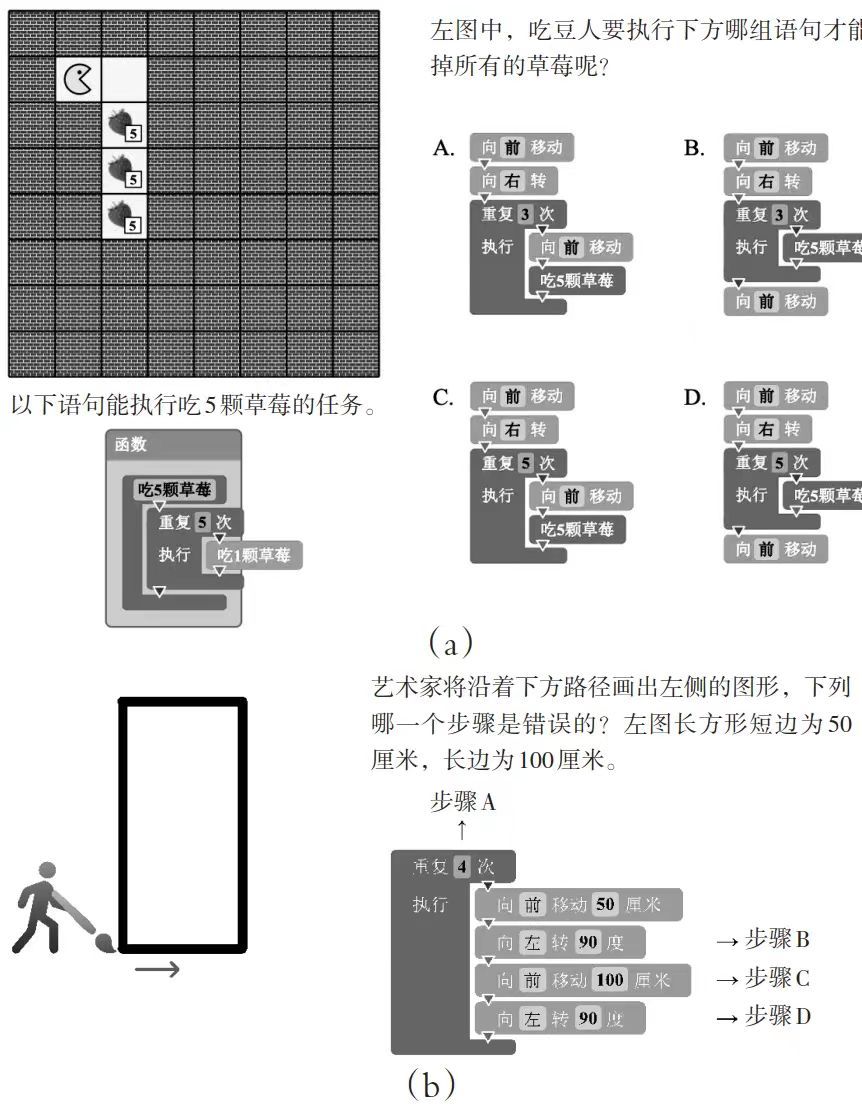

通过梳理计算思维的内涵可以发现,计算思维涉及计算机科学以及普适化问题解决两个方面,因此,其测评应当从多角度全面反映学习者的计算思维水平(Grover,2015;马宗兵等,2021)。计算思维测评工具的开发需要一定的理论作为指导,这是其科学性与有效性的重要保证(惠恭健等,2020)。在众多的计算思维理论模型中,较为典型的是Brennan等提出的计算思维三维框架,具体包含计算概念、计算实践和计算观念三个维度。其中,计算概念指的是基于编程语言的一系列概念,如序列、循环、条件等;计算实践指的是在编程过程中运用编程概念解决问题的一些常规做法,如调试、测试等;计算观念指的是个体对自己、与他人的关系以及对周围数字世界的理解,如利用计算思维进行问题的抽象、分解等(Brennan et al.,2012)。本研究基于计算思维三维框架,对国内外K-12阶段的典型计算思维测评工具进行梳理,结果如表1所示。可以看出,从计算机科学视角开展的测评多针对计算概念和计算实践两个维度,此类测评多采用特定编程系统环境作为测评介质,需结合相应的课程教学方能实施,难以在大规模测评中进行迁移和应用。少数采用在线测试的测评工具,其试题也大多结合课程教学进行设计。基于计算机科学视角的测评工具中,仅有Román-González等(2017)所设计的CTT(Computational Thinking Test)试题不需要结合特定的课程教学即可实施。CTT试题的开发充分考虑以下三个原则:一是清晰的目标定位,即从计算机科学视角出发测量学生的计算思维发展,测量涵盖了最基本的计算概念;二是测量的可操作性,即试题基于可视化编程语言界面进行设计,题目以迷宫或画布的形式呈现,选项则采用可视化箭头和可视化方块,这使得测试能够不依靠具体课程教学而开展;三是明确的目标群体,即试题所针对的目标群体为5~10年级的学生,全部28道试题的完成时间约为45分钟,可等分为两套完整的试题,能够应用于前后测或较短时长的大规模测试中。

表1 K-12阶段典型计算思维测评工具梳理

从普适化视角开展的测评大多以学习结果为导向,即将计算思维视作学生高阶思维能力发展的结果,涉及创造力、批判思维、问题解决能力、算法思维和合作能力等,实际测量的维度是计算观念。Korkmaz等(2017)基于ISTE对计算思维的理论框架分析和前人研究开发了较为经典的计算思维量表(Computational Thinking Scale,CTS),该量表涉及创造力、算法思维、合作能力、批判性思维和问题解决能力5个维度,共计29道题目。白雪梅等(2019)将Korkmaz等的CTS翻译成中文,并应用于高中生的计算思维评价,研究结果表明其在我国高中学段具有较好的适用性。张屹等(2020)将Korkmaz等的CTS在小学阶段进行本土化应用,发现其信效度不高,于是仅采用原始CTS中的算法思维和合作能力维度题目,其余3个维度的题目则改编自其他成熟量表,针对3~6年级小学生开展的调查结果显示,该量表可有效测评我国小学生的计算思维水平。

充分考虑学生的思维过程是有效培养学生计算思维的重要前提,然而在当前研究中,鲜有研究从思维过程的维度对小学生的计算思维进行测评。Kukul等(2019)从思维过程出发,将计算思维分解为推理、抽象、分解和泛化四个维度,并基于此设计了面向初中生的测量量表。Tsai 等(2020)基于已有研究开发了以思维过程为导向的CTS,其包括5个基本要素:抽象,即关注问题解决的关键信息而非细节;分解,即将问题分解成易于处理的子问题;算法思维,即通过分步程序来设计问题解决方案;评价,即通过比较找到最佳问题解决方案;泛化,即掌握解决特定问题的模式并将其应用于类似问题的解决。实证结果表明,该量表能够对小学生群体在思维过程中表现出的计算观念进行有效测量(Tsai et al.,2022)。

综上可知,从计算机科学视角出发的计算思维测评工具多从计算概念和计算实践维度进行测量。此类测量工具中,Román-González等(2017)开发的CTT因遵循清晰的原则故更适用于小学生群体计算思维的大规模测评;而从普适化视角出发设计的计算思维评价工具则多针对计算观念维度,相较而言,Tsai等(2020)的CTS通过聚焦思维过程来测量学生的计算思维,能更好地反映学生在认知层面的计算思维发展。然而,目前还鲜有结合计算机科学和普适化视角的计算思维综合测评方案,因此,本研究从计算思维三维框架出发,基于Román-González等(2017)的CTT 和Tsai等(2020)的CTS开发了针对小学生的计算思维综合测评方案。

二、研究设计

1.研究对象

2019年,教育部将S市作为首批开展中小学校人工智能教育试点的5个城市之一。S市从3年级开始设置信息技术课程,学生从4年级开始学习机器人及编程相关知识,整体而言其编程教育普及较好。本研究选取S市已接受编程教育的4~6年级小学生作为研究对象,原因如下:第一,该市小学生虽从3年级开始学习信息技术课程,但尚未接触编程相关学习内容,且未具备足够的理解能力以完成测评;第二,小学4年级的学生能够初步理解计算思维相关概念及相关测评量表和试题的含义;第三,不同年级小学生处于认知发展不同阶段,选取多年级学生有助于发现计算思维和认知发展的关联。本研究共收集到样本数据1304份,其中有效样本数据1030份,包括男生517人(占50.20%),女生513人(占49.80%);4年级学生251人(占24.37%),5年级学生575人(占55.83%),6年级学生204人(占19.80%)。

2.研究工具

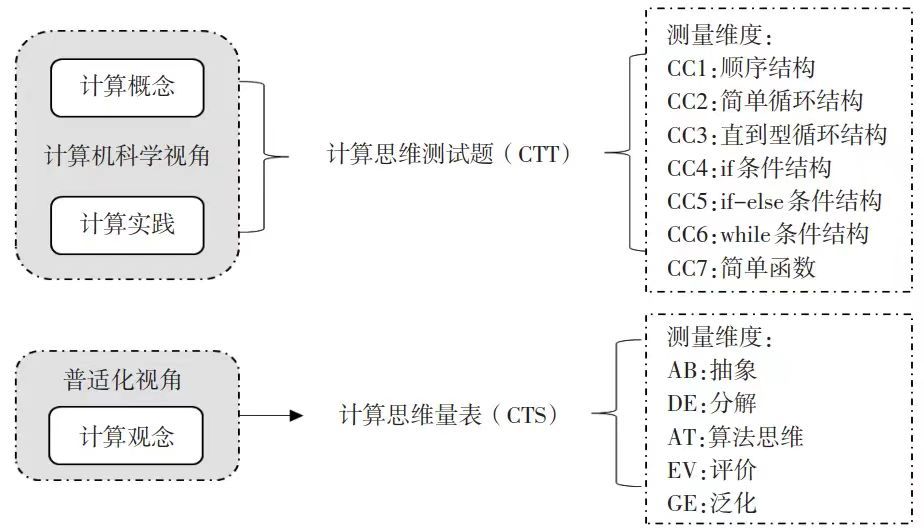

本研究通过整合计算思维的计算机科学和普适化视角,从计算概念、计算实践和计算观念三个维度出发,构建了面向小学生的计算思维综合测评方案 (见图1)。在计算概念和计算实践的测评方面,选取Román-González等(2017)开发的计算思维测试题(简称CTT)。原版CTT共28道测试题,分为7组(每组4题),涉及顺序结构、简单循环结构、直到型循环结构、if条件结构、if-else条件结构、while条件结构以及简单函数等7种计算概念,在运用计算概念完成测评试题过程中主要体现了调试和纠错、再利用和再创作、抽象化和模块化等3种计算实践,试题满分为28分。通过前期预实验发现,小学生往往难以在常规课堂时间内完成完整测试,故参考应用CTT开展小学生计算思维测评的相关研究(Tsarava et al.,2022),将其拆分为两套各14题的分割版测试题(A、B卷,在实际测评时随机分配),两套测试题测评的计算概念和计算实践相同,满分均为14分。在计算观念的测评方面,选取Tsai等(2020)开发的计算思维量表(简称CTS),共有19道采用五点李克特量表的试题。

图1 基于三维框架的小学生计算思维综合测评方案

为确保测评方案有效应用于本土化情境,笔者将原始CTT的可视化界面迁移到中文编程软件中,并遵循中文表达习惯对原始CTT和CTS进行翻译。随后,邀请两位精通英语的教育技术学专家对翻译后的测量工具进行校验,并随机抽取5名小学生进行预测试,而后根据反馈意见对测量工具进行完善。本土化迁移后的CTT测试题示例如图2所示。

图2 CTT测试题示例

三、数据分析

1.CTT信效度分析

为检验将CTT分割为A、B卷后是否产生难度系数差异,本研究采用“试卷得分均值/试卷总分”的方式计算A、B卷的难度系数,其中A卷的难度系数为0.5764,B卷的难度系数为0.5757,可见,A、B两套试卷的难度系数相当。从不同年级的答题情况来看,总体呈现年级越高得分越高的趋势,4~6年级的得分分别为7.63、8.19、8.24。此外,A、B卷的得分均符合正态分布,且所有学生均能在20分钟内完成所有的题项。研究采用Spearman-Brown公式对CTT进行信度检验,该公式通过纳入由于测试题量改变而造成的测量误差,对Cronbach’s α系数进行修正,从而更准确地评价测试题的信度。其计算方式为

,其中n为总题量与当前题量的比值。研究首先针对A卷和B卷进行内部一致性检验,其Cronbach’s α系数分别为0.569和0.512,根据Spearman-Brown公式(n=2)修正后的Cronbach’s α系数分别为0.725和0.677(均大于0.6),故A、B卷均具有良好的信度。

2.CTS信效度分析

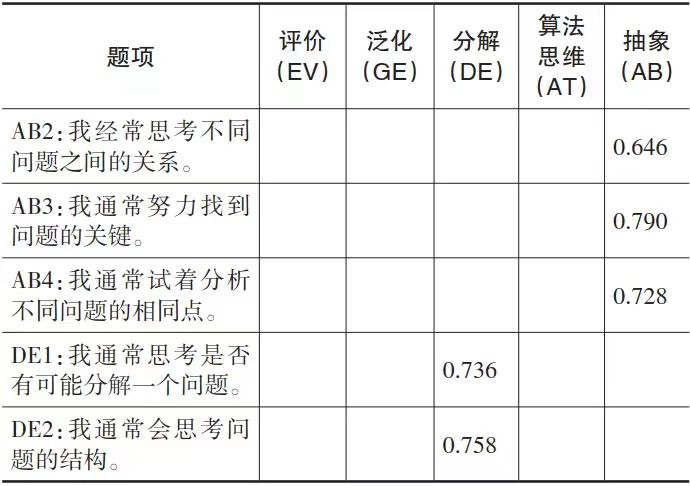

研究将数据随机均分成两个部分,一部分数据(n=515)用于探索性因子分析,另一部分数据(n=515)用于验证性因子分析。Barlett’s球形检验结果显示,KMO=0.95(>0.8),χ2(171)=6484.3,p<0.001,故适合开展探索性因子分析。进而通过主成分分析提取因子(预设因子数为5),旋转后的成分矩阵显示“抽象”维度测量指标AB1的归类结果与原量表不一致,且“算法思维”和“评价”两个维度的测量指标被归类到同一成分。进一步分析相关性矩阵发现,AB1与“抽象”维度的其他测量指标相关性较低,故考虑删除AB1。删除AB1后的探索性因子分析结果显示,各测量指标因子负荷均大于0.6,且归类结果均与原量表一致,累计解释变异量达75.11%(见表2),表明删除AB1后的量表具有较好的结构效度。验证性因子分析结果亦显示,样本数据与CTS的5因子结构模型拟合良好(IFI=0.983,CFI=0.983,NFI=0.973,GFI=0.963,均大于0.9)。

表2 CTS的探索性因子分析结果

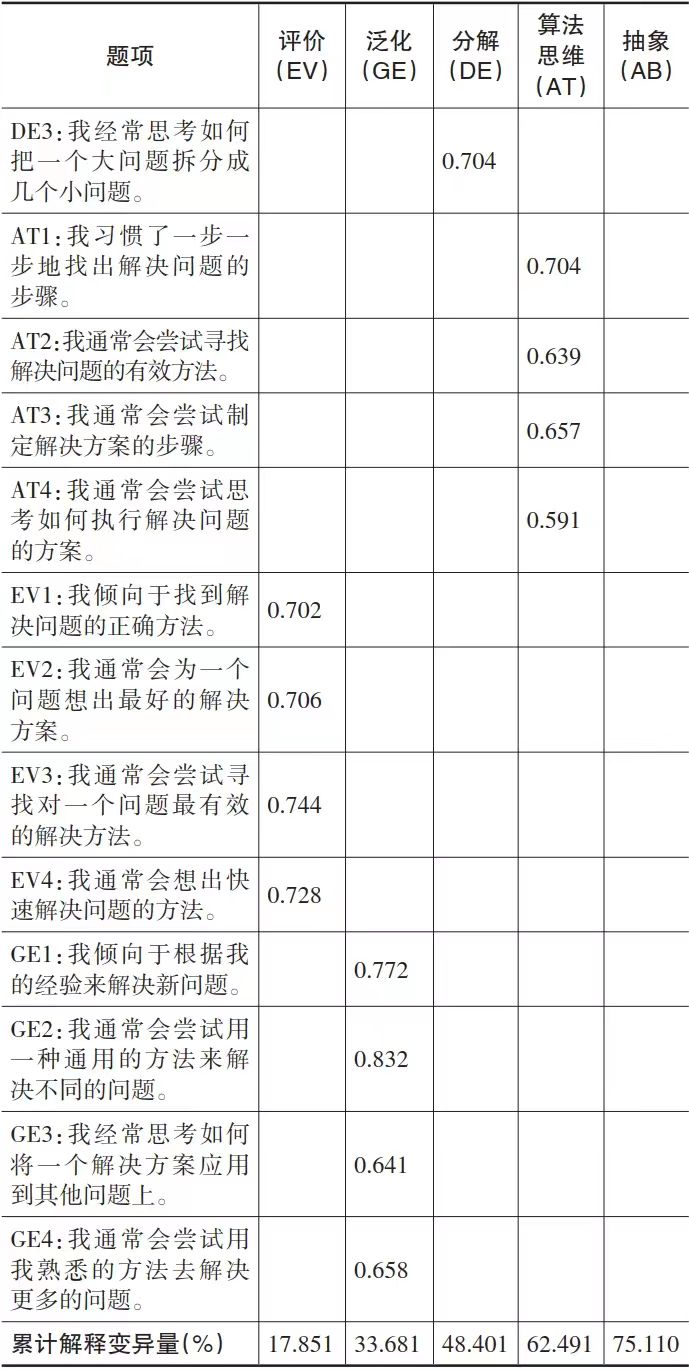

对调整后的CTS进行内部一致性检验(见表3),结果显示各维度的Cronbach’s α系数及组合信度(Composite Reliability,CR)均大于0.8,表明5个因子的内部一致性良好;平均方差萃取量(Average of Variance Extracted,AVE)均大于0.5,表明调整后的CTS各维度具有较好的收敛效度。

表3 调整后的CTS内部一致性检验结果

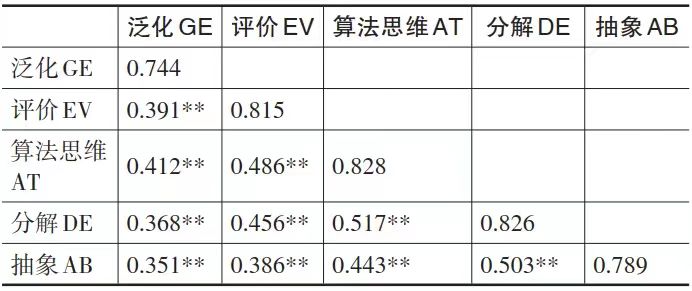

利用 AVE的平方根来分析调整后的CTS的5个维度之间的区分效度,如表4所示。其中,对角线上的值为各维度的AVE平方根,该值均大于与其他维度的相关系数,表明调整后的CTS具有较好的区分效度。

表4 调整后的CTS的区分效度

(注:**p<0.01。)

上述分析表明,调整后的CTS具有良好的模型拟合度、收敛效度和区分效度,这进一步支持了探索性因子分析的结果,说明调整后的CTS可以有效测量小学生群体的计算观念。

3.小学生计算思维总体状况及差异分析

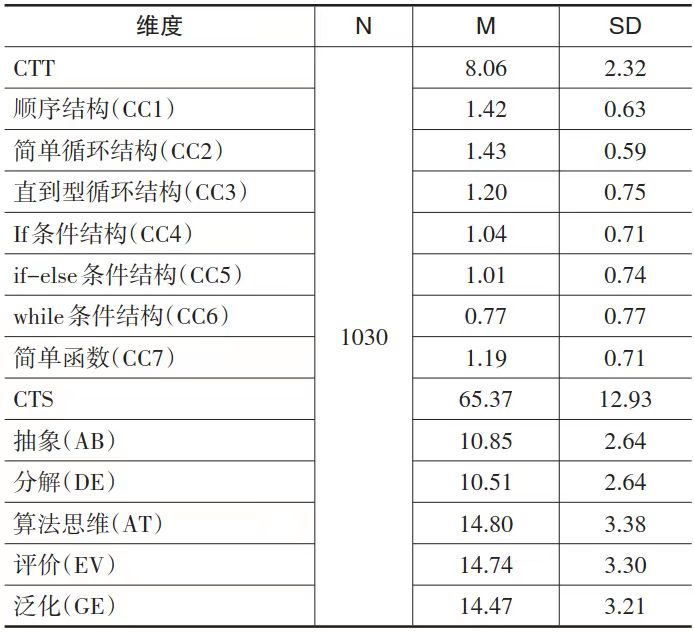

(1)总体状况分析小学生计算思维总体状况如表5所示。从CTT得分来看(满分14分),平均值为8.06分,其中得分达到合格水平线(1.2分)的有简单循环结构(1.43分)、顺序结构(1.42分)和直到型循环结构(1.20分),而简单函数(1.19分)、if条件结构(1.04分)、if-else条件结构(1.01分)和while条件结构(0.77分)则未达到及格水平。从CTS测评结果来看,平均值为65.37,从高到低依次为算法思维(14.80)、评价(14.74)、泛化(14.47)、抽象(10.85)和分解(10.51),每个维度均达到中上水平。综上可见,小学生在计算概念和计算实践维度上的表现部分达标,在涉及条件结构各指标上的表现距离达标有一定差距,在计算观念维度上的表现较佳。

表5 小学生计算思维总体状况

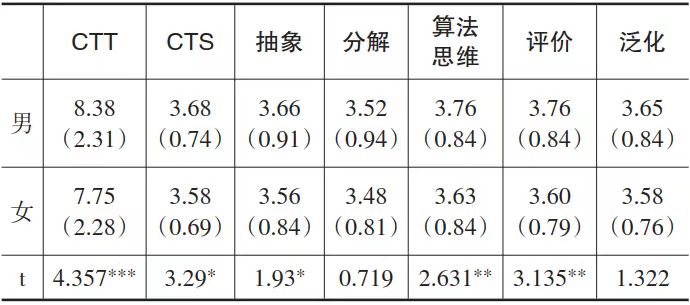

(2)性别及年级差异分析研究采用独立样本T检验考察不同性别学生在计算思维上的差异,结果如表6所示。可以看出,男生在CTT和CTS上的表现均显著优于女生。具体从CTS各子维度来看,男生在抽象、算法思维、评价维度上的分值显著高于女生。

表6 小学生计算思维在性别上的差异分析

(注:*p<0.05,**p<0.01,***p<0.001;括号外为均值,括号内为标准差。)

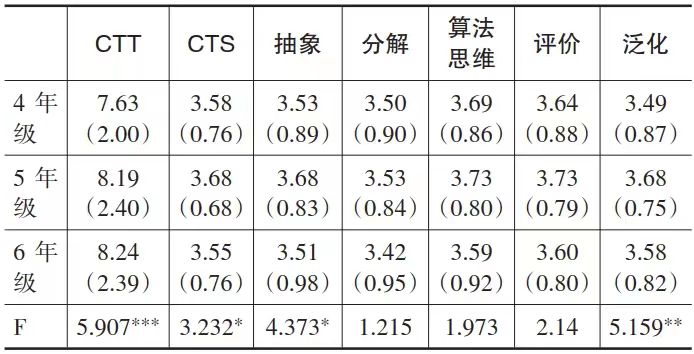

表7 小学生计算思维在年级上的差异分析

(注:同表6。)

研究采用单因素方差分析考察不同年级学生在计算思维上的差异,结果如表7所示。可以看出,5年级和6年级学生在CTT上的得分显著优于4年级学生,5年级学生在CTS的5个子维度上的分值均高于4年级和6年级学生,且事后检验结果表明,5年级学生在抽象和泛化维度上的分值分别显著高于6年级和4年级学生。

四、结果讨论

1.基于三维框架的综合测评方案可用于评价小学生计算思维

针对目前缺乏综合计算机科学和普适化视角对我国小学生计算思维水平进行全面测评的现状,本研究以计算思维三维框架为理论基础,建构了整合计算概念、计算实践和计算观念的小学生计算思维综合测评方案。在计算机科学视角方面,考虑到测评对象实际情况,将计算思维测试题CTT拆分成A、B卷,难度系数分析和内部一致性检验结果显示拆分后的CTT能够有效测量小学生计算概念和计算实践。在普适化视角方面,针对计算思维量表CTS进行的探索性因子分析发现,“抽象”维度的测量指标AB1与其他题项相关性不佳,其原因可能有二:一是小学生更加关注解决问题的细节,而不太擅长从整体的角度思考问题;二是该指标需要通过逆向思维做出选择,这对小学生的认知可能具有一定挑战。调整后的CTS包含抽象、分解、算法思维、评价和泛化等5个维度的18个指标,能够对小学生计算观念进行有效测量。总体上,该计算思维综合测评方案可以用于评价小学生的计算思维,从而帮助教师更为全面地了解学生的计算思维发展水平。

2.整体计算思维水平表现中等且在部分维度上仍有待提升

《信息科技新课标》明确了小学5~6年级需掌握的计算思维学段目标,即“对于给定的任务,能将其分解为一系列的实施步骤,使用顺序、分支、循环三种基本控制结构简单描述实施过程”(中华人民共和国教育部,2022)。本研究发现,小学生在计算概念和计算实践上的表现部分达到《信息科技新课标》的计算思维学段目标,但在分支结构(if、if-else、while等条件结构)和简单函数方面未达到及格水平。在编程中,条件结构以条件判断为起始点,根据条件是否成立决定执行哪一个处理步骤(李建华,2004)。条件结构和简单函数往往涉及“嵌套”元素,这可能使小学生对其理解感到吃力。因此,教师在编程课程中应当针对条件结构开展循序渐进的教学,例如可在教授循环结构时融入简单的条件结构,然后再进行多重条件结构的教学。此外,教师在开展函数相关知识点的教学前,应当明确学生对三种基本控制结构的掌握程度,并按照学情适当地将后者融入相关知识点的讲授。

测评结果表明,小学生在计算观念上的表现中等,基本达到了《信息科技新课标》关于计算思维的学段目标。《信息科技新课标》要求,3~4年级学生应具备“在简单问题的解决过程中,有意识地把问题划分为多个可解决的小问题,通过解决各个小问题,实现整体问题解决”的能力,5~6年级学生应具备“在问题解决过程中,能将其分解为可处理的子问题”以及“对于给定的任务,能将其分解为一系列的实施步骤”的能力(中华人民共和国教育部,2022)。相较其他计算观念子维度而言,本研究发现各年级学生在“分解”维度上的表现仍有较大提升空间。因此,在面向小学学段的计算观念培养过程中,教师需适当加强对“分解”观念的培养,通过训练学生将大目标拆分成多个有机组成的阶段性目标的能力,更好地促进其计算思维发展。

3.小学生计算思维在性别和年级上存在显著差异

测评结果显示,男生在计算概念和计算实践上的得分显著高于女生,这与Korkmaz等(2017)的研究发现相一致。就计算观念而言,男生在抽象、算法思维和评价子维度上的表现亦显著优于女生。值得注意的是,随着年级的增长,男女生间的计算思维水平差异呈现出减小的趋势。前人研究指出,女生对自己在这些方面的能力不够自信或者女生确实在这些方面存在一定劣势(白雪梅等,2019),并且女生需要更多的训练时间才能在STEM课程中达到与男孩相似的计算思维技能水平(Atmatzidou et al.,2016)。因此,在小学生计算思维培养过程中,应该更多地鼓励女生参与相关实践活动,尤其应当重视对女生抽象、算法思维及评价等维度能力的培养。

从不同年级小学生间的差异来看,5年级和6年级学生在计算概念和计算实践上的得分显著高于4年级的学生。发展心理学认为,个体自5年级(11~12岁)开始发展出较为复杂的逻辑分析和推理能力,这往往是4年级(10岁)以下学生所欠缺的(Clement et al.,1986),这为5、6年级学生在CTT得分上优于4年级学生提供一定的解释。5年级学生在计算观念上的分值高于4年级和6年级学生,这说明随年龄增长而获得的认知发展并不能直接转换为学生在计算观念上的提升(张屹等,2020)。具体来看,5年级学生在抽象和泛化子维度上的得分显著高于6年级和4年级学生。抽象思维反映出学生对解决问题核心要素的提取能力,泛化思维则强调将特定问题的解决模式应用到类似问题的解决中,此类高阶思维技能往往与自我效能感密切相关。5年级学生开始接触Scratch编程等内容,在此阶段他们对编程抱有浓厚兴趣,随着年级的增加,学生反而感觉编程学习没有了初次接触时吸引力,编程的自我效能也随之降低(Kong et al.,2018),这或许是5年级学生在上述两个维度显著优于其他年级学生的原因。可见,激发小学生对编程的热情和兴趣,对于培养其计算思维具有重要作用。

五、研究启示

随着《信息科技新课标》的实施落地,计算思维已经成为义务教育全学段的培养目标,其有效测评成为落实新课标的关键。通过梳理计算思维内涵可以发现,计算思维不仅涉及从计算机科学视角出发强调解决编程相关问题的能力,还涉及从普适化视角出发解决日常学习与生活问题的能力,因此,应综合运用多种测评工具方能全面客观地反映学生真实的计算思维水平。本研究构建了小学生计算思维综合测评方案,从计算概念、计算实践和计算观念等维度对小学生计算思维水平进行评价,基于研究发现得出如下启示:

1.注重从多角度综合测评小学生的计算思维水平

首先,计算思维的测评应当从原理理解和项目实践两方面构建评价体系(任友群等,2016),既反映个体对计算机学科核心概念和方法的掌握,又反映将其运用于解决普适化问题的能力。其次,在测评工具的选择上,需要合理采用基于自我报告的量表和面向计算机学科知识的测试题等多种形式,从概念、实践和观念等维度对小学生的计算思维水平进行全面测量。再次,在测评内容的呈现上,应当充分考虑到小学生的认知发展特点,尽量采用图文结合的呈现形式以便于其理解(Román-González et al.,2017),此外也可采用游戏化的测评方式以激发学生兴趣。最后,在测评的实施过程中,还需要考虑到小学课堂的实际情境,从编程环境、测试时长、答题方式等方面对测评方案进行细致设计。

2.注重通过情境问题解决促进小学生计算思维培育

编程实践是培养小学生计算思维的有效途径。本研究发现,5年级学生在计算观念上的整体表现优于4、6年级学生,这或许与5年级学生刚开始接触Scratch等可视化编程工具时抱有较高学习兴趣有关。因此,教师在信息科技课程的教学过程中,应当将顺序结构、循环结构、条件结构和简单函数等编程知识的讲授与具体的情境化问题解决相结合,激发和保持学生学习编程的兴趣和热情。值得注意的是,当前小学阶段的信息科技课程仍以信息技术操作技能作为主要学习内容,这导致学生在算法思维和问题解决能力上的表现不佳(张屹等,2020)。因此,教师在设计课程内容时,应当将问题分解、抽象等计算思维培养目标与真实情境相结合,以培养学生运用计算思维解决跨学科问题的能力。

3.针对不同性别学生采取差异化计算思维培养策略

本研究发现,小学生在计算思维综合测评中体现出显著的性别差异,具体表现为男生在计算概念、计算实践以及计算观念的抽象、算法思维和评价子维度均优于女生。这意味着教师需要正视男女生在计算思维发展上的差异,并在培养策略上有所侧重:首先,在抽象、算法思维以及评价维度的计算思维培养上,教师可以通过设置分层任务,给予女生足够的参与机会和练习时间(Atmatzidou et al.,2016)。其次,教师可以在课程活动中有针对性地为男女生分配不同的任务角色,如鼓励男生参与更具操控性的课程活动,而让女生承担更需要团队协作的设计活动(Angeli et al.,2020),并通过增加女生感兴趣的学习主题等形式鼓励其参与。

参考文献:

[1]白雪梅,顾小清(2019).K12阶段学生计算思维评价工具构建与应用[J].中国电化教育,(10):83-90.

[2]范文翔,张一春,李艺(2018).国内外计算思维研究与发展综述[J].远程教育杂志,36(2):3-17.

[3]惠恭健,兰小芳,钱逸舟(2020).计算思维该如何评?——基于国内外14种评价工具的比较分析[J].远程教育杂志,38(4),84-94.

[4]蒋宗礼(2013).计算思维之我见[J].中国大学教学,(9):5-10.

[5]李建华(2004).算法及其教育价值[J].数学教育学报,(3):46-47.

[6]马宗兵,谭春兰(2021).面向小学生的CTT-BS-CTS三维计算思维评价方案[J].中国教育信息化,(24):81-87.

[7]任友群,隋丰蔚,李锋(2016).数字土著何以可能?——也谈计算思维进入中小学信息技术教育的必要性和可能性[J].中国电化教育,(1):2-8.

[8]孙丹,李艳(2019).国内外青少年编程教育的发展现状、研究热点及启示——兼论智能时代我国编程教育的实施策略[J].远程教育杂志,37(3):47-60.

[9]张屹,莫尉,张岩等(2020).我国小学生计算思维量表研发与应用[J].中国电化教育,(10):49-57.

[10]中华人民共和国教育部(2020).教育部关于印发普通高中课程方案和语文等学科课程标准(2017年版2020年修订)的通知[EB/OL].[2022-04-27].http://www.moe.gov.cn/srcsite/A26/s8001/202006/t20200603_462199.html.

[11]中华人民共和国教育部(2022).教育部关于印发义务教育课程方案和课程标准(2022年版)的通知[EB/OL].[2022-04-27].http://www.moe.gov.cn/srcsite/A26/s8001/202204/t20220420_619921.html.

[12]周佳伟,王祖浩(2018).科学教育中的计算思维:理论框架与课程设计[J].中国电化教育,(11):72-78.

[13]朱亚宗(2009).论计算思维——计算思维的科学定位、基本原理及创新路径[J].计算机科学,36(4):53-55,93.

[14]Angeli, C., & Valanides, N. (2020). Developing Young Children’s Computational Thinking with Educational Robotics: An Interaction Effect Between Gender and Scaffolding Strategy[J]. Computers in Human Behavior, 105:105954.

[15]Atmatzidou, S., & Demetriadis, S. (2016). Advancing Students’ Computational Thinking Skills Through Educational Robotics: A Study on Age and Gender Relevant Differences[J]. Robotics and Autonomous Systems, 75:661-670.

[16]Basu, S., Biswas, G., & Kinnebrew, J. S. (2017). Learner Modeling for Adaptive Scaffolding in a Computational Thinking-Based Science Learning Environment[J]. User Modeling and User-Adapted Interaction, 27(1):5-53.

[17]Brennan, K., & Resnick, M. (2012). New Frameworks for Studying and Assessing the Development of Computational Thinking[C]// Proceedings of the 2012 Annual Meeting of the American Educational Research Association. Vancouver, Canada: AERA:1-25.

[18]Clement, C. A., Kurland, D. M., & Mawby, R. et al. (1986). Analogical Reasoning and Computer Programming[J]. Journal of Educational Computing Research, 2(4):473-486.

[19]Denning, P. J. (2007). Computing is a Natural Science[J]. Communications of the ACM, 50(7):13-18.

[20]Denning, P. J. (2017). Viewpoint Remaining Trouble Spots with Computational Thinking[J]. Communications of the ACM, 60(6):33-39.

[21]Duncan, C., & Bell, T. (2015). A Pilot Computer Science and Programming Course for Primary School Students[C]// Proceeding of the Workshop in Primary and Secondary Computing Education. London, UK: ACM:39-48.

[22]Grover, S. (2015). “Systems of Assessments” for Deeper Learning of Computational Thinking in K-12[C]// Proceedings of the 2015 Annual Meeting of the American Educational Research Association. Chicago, USA: AERA:15-20.

[23]Grover, S., Pea, R., & Cooper, S. (2015). Designing for Deeper Learning in a Blended Computer Science Course for Middle School Students[J]. Computer Science Education, 25(2):199-237.

[24]Guzdial, M. (2008). Education: Paving the Way for Computational Thinking[J]. Communications of the ACM, 51(8):25-27.

[25]ISTE & CSTA (2011). Operational Definition of Computational Thinking for K-12 Education[EB/OL]. [2022-04-27].

[26]Koh, K. H., Basawapatna, A., & Nickerson, H. et al. (2014). Real Time Assessment of Computational Thinking [C]// Proceedings of the 2014 IEEE Symposium on Visual Languages and Human-Centric Computing (VL/HCC). Melbourne, Australia: IEEE:49-52.

[27]Kong, S. C., Chiu, M. M., & Lai, M. (2018). A Study of Primary School Students’ Interest, Collaboration Attitude, and Programming Empowerment in Computational Thinking Education[J]. Computers & Education, 127:178-189.

[28]Korkmaz, Ö., Çakir, R., & Özden, M. Y. (2017). A Validity and Reliability Study of the Computational Thinking Scales (CTS)[J]. Computers in Human Behavior, 72:558-569.

[29]Kukul, V., & Karatas, S. (2019). Computational Thinking Self-Efficacy Scale: Development, Validity and Reliability[J]. Informatics in Education, 18(1):151-164.

[30]Moreno-León, J., Robles, G., & Román-González, M. (2015). Dr. Scratch: Automatic Analysis of Scratch Projects to Assess and Foster Computational Thinking[J]. RED-Revista de Educación a Distancia, (46):1-23.

[31]Ota, G., Morimoto, Y., & Kato, H. (2016). Ninja Code Village for Scratch: Function Samples/Function Analyser and Automatic Assessment of Computational Thinking Concepts[C]// Proceedings of the 2016 IEEE Symposium on Visual Languages and Human-Centric Computing (VL/HCC). Cambridge, UK: IEEE:238-239.

[32]Polat, E., Hopcan, S., & Kucuk, S. et al. (2021). A Comprehensive Assessment of Secondary School Students’ Computational Thinking Skills[J]. British Journal of Educational Technology, 52(5):1965-1980.

[33]Román-González, M., Pérez-González, J. C., & Jiménez-Fernández, C. (2017). Which Cognitive Abilities Underlie Computational Thinking? Criterion Validity of the Computational Thinking Test[J]. Computers in Human Behavior, 72:678-691.

[34]Sáez-López, J. M., Román-González, M., & Vázquez-Cano, E. (2016). Visual Programming Languages Integrated Across the Curriculum in Elementary School: A Two Year Case Study Using “Scratch” in Five Schools[J]. Computers & Education, 97:129-141.

[35]Seiter, L., & Foreman, B. (2013). Modeling the Learning Progressions of Computational Thinking of Primary Grade Students[C]// Proceedings of the Ninth Annual International ACM Conference on International Computing Education Research. San Diego, USA: ACM:59-66.

[36]Tsai, M. J., Chien, F. P., & Wen-Yu L. S. et al. (2022). Development and Validation of the Computational Thinking Test for Elementary School Students (CTT-ES): Correlate CT Competency with CT Disposition[J]. Journal of Educational Computing Research, 60(5):1110-1129.

[37]Tsai, M. J., Liang, J. C., & Hsu, C. Y. (2020). The Computational Thinking Scale for Computer Literacy Education[J]. Journal of Educational Computing Research, 59(4):579-602.

[38]Tsarava, K., Moeller, K., & Román-González, M. et al. (2022). A Cognitive Definition of Computational Thinking in Primary Education[J]. Computers & Education, 179:104425.

[39]Werner, L., Denner, J., & Campe, S. et al. (2012). The Fairy Performance Assessment: Measuring Computational Thinking in Middle School[C]// Proceedings of the 43rd ACM Technical Symposium on Computer Science Education. New York, USA: ACM:215-220.

[40]Wing, J. M. (2006). Computational Thinking[J]. Communications of the ACM, 49(3):33-35.

[41]Wing, J. M. (2008). Computational Thinking and Thinking About Computing[J]. Philosophical Transactions of the Royal Society A: Mathematical, Physical and Engineering Sciences, 366(1881):3717-3725.

[42]Witherspoon, E. B., Higashi, R. M., & Schunn, C. D. et al. (2017). Developing Computational Thinking Through a Virtual Robotics Programming Curriculum[J]. ACM Transactions on Computing Education, 18(1):1-20.

[43]Zhong, B., Wang, Q., & Chen, J. et al. (2016). An Exploration of Three-Dimensional Integrated Assessment for Computational Thinking[J]. Journal of Educational Computing Research, 53(4):562-590.

编辑:徐航 校对:罗添 预审:施羽晗 终审:聂竹明